主要研究论文:

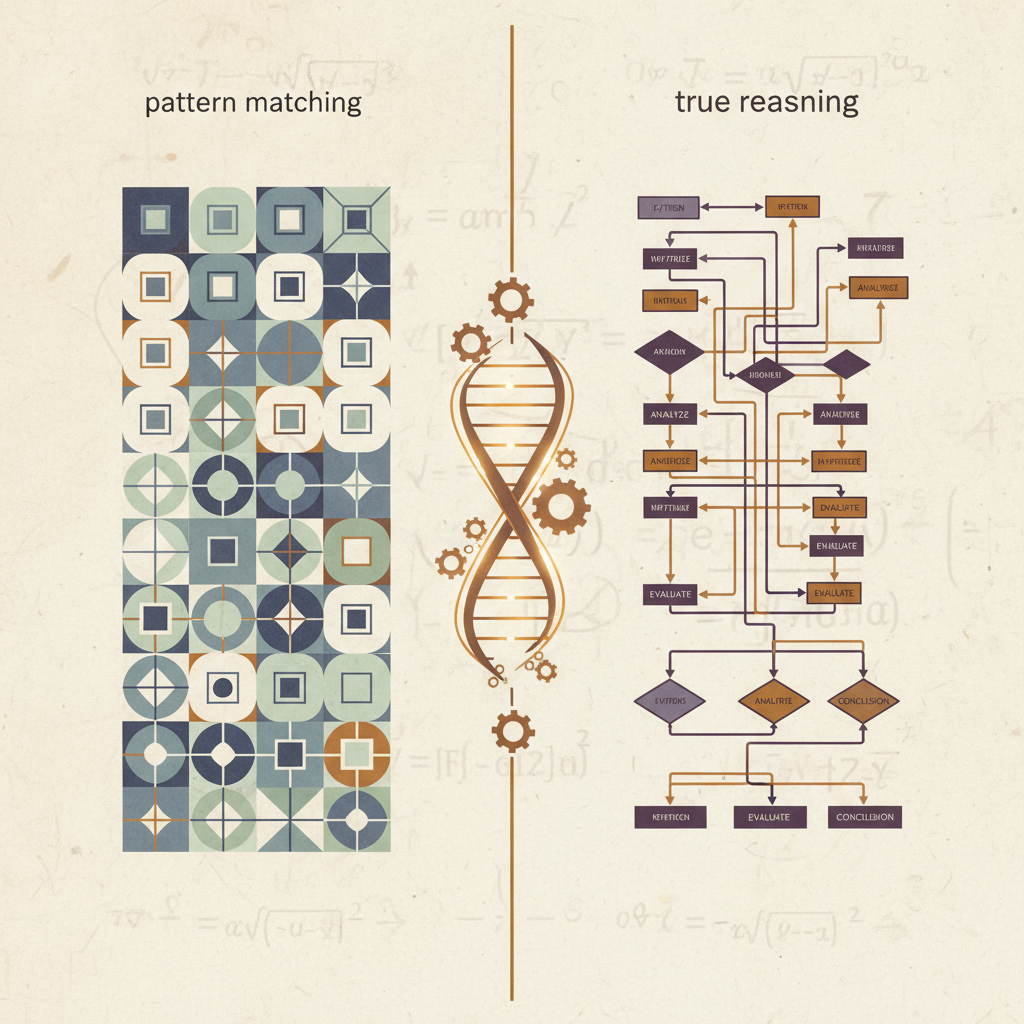

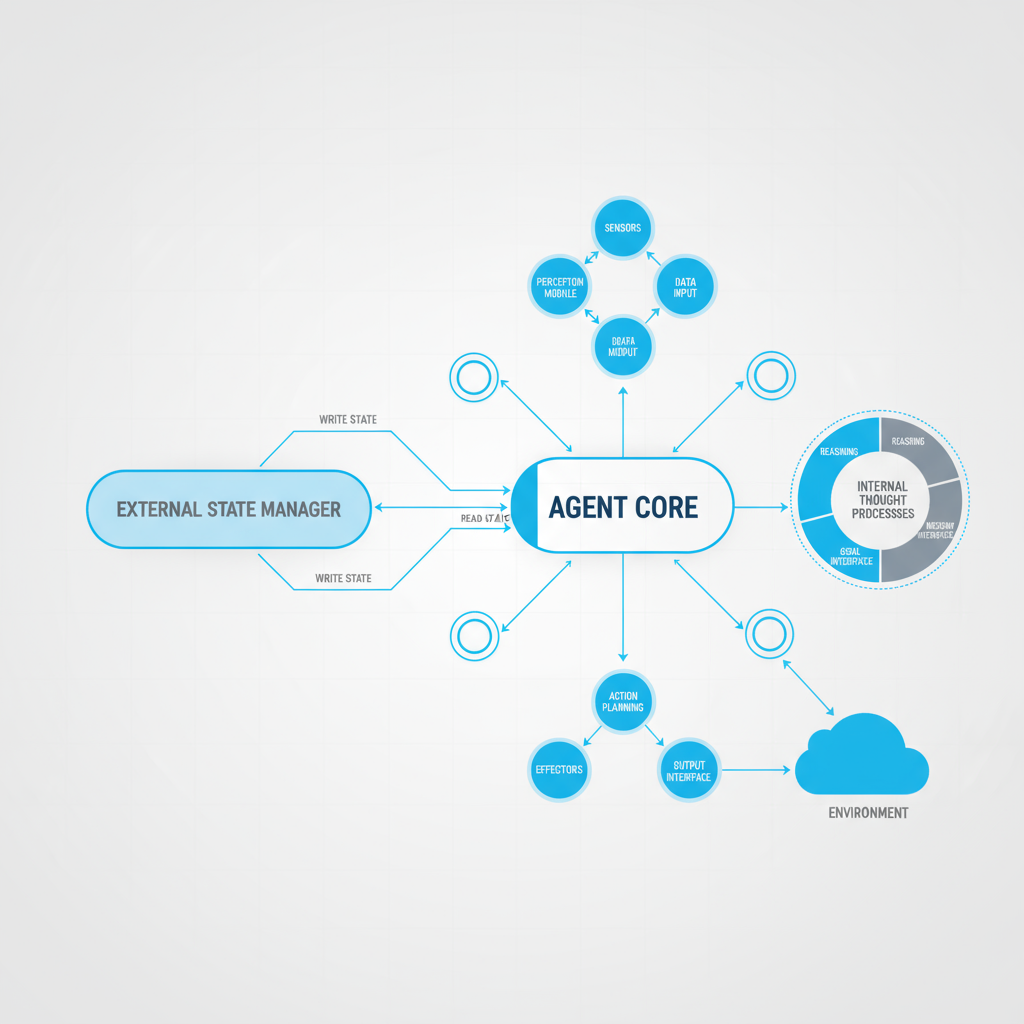

Shojaee, P., et al. (2025). "The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity." Apple Machine Learning Research.

后续研究:

Dellibarda Varela, I., et al. (2025). "Rethinking the Illusion of Thinking." arXiv:2507.01231v1.

相关研究:

Mirzadeh, I., et al. (2024). "GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models." Apple.

技术分析:

Various authors. "The Illusion of Thinking: What the Apple AI Paper Says About LLM Reasoning." Arize AI, 2025.